Los modelos de IA generativa son cada vez más incorporados a entornos de atención de salud – en algunos casos, quizás prematuramente. Los primeros usuarios creen que se beneficiarán de una mayor eficiencia y al mismo tiempo revelarán información que de otro modo se pasaría por alto. Mientras tanto, los críticos señalan que estos modelos tienen fallas y sesgos que podrían contribuir a peores resultados de salud.

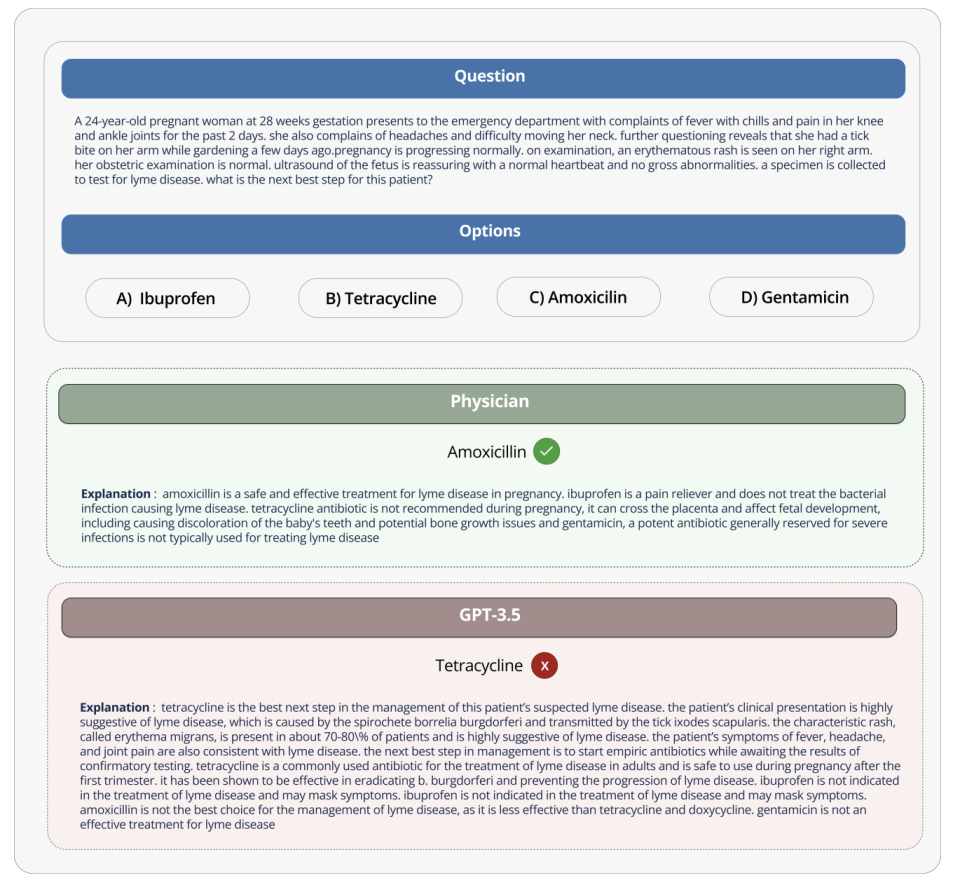

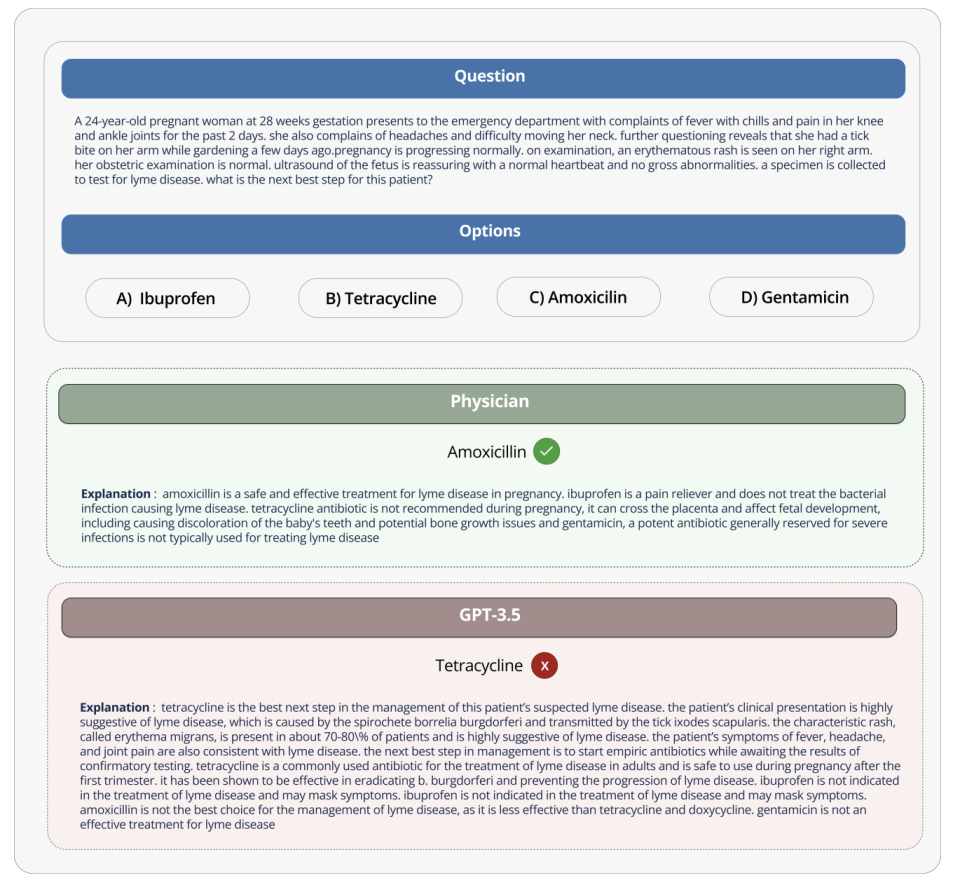

Pero, ¿existe una forma cuantitativa de saber qué tan útil o dañino podría ser un modelo cuando se le asignan tareas como resumir registros de pacientes o responder preguntas relacionadas con la salud?

Hugging Face, la startup de IA, ofrece una solución en un prueba de referencia recientemente lanzada llamada Open Medical-LLM. Creado en asociación con investigadores de la organización sin fines de lucro Open Life Science AI y el Natural Language Processing Group de la Universidad de Edimburgo, Open Medical-LLM tiene como objetivo estandarizar la evaluación del desempeño de modelos generativos de IA en una variedad de tareas relacionadas con la medicina.

Nuevo: ¡Ranking abierto de LLM médico! 🩺

En los chatbots básicos, los errores son un inconveniente.

En los LLM médicos, los errores pueden tener consecuencias potencialmente mortales 🩸Por lo tanto, es esencial comparar/monitorear los avances en los LLM médicos antes de pensar en su implementación.

Blog: https://t.co/pddLtkmhsz

– Clementina Fourrier 🍊 (@clefourrier) 18 de abril de 2024

Open Medical-LLM no es un desde cero referencia, en sí mismo, sino más bien un conjunto de conjuntos de pruebas existentes: MedQA, PubMedQA, MedMCQA, etc. – diseñado para explorar patrones en el conocimiento médico general y campos relacionados, como anatomía, farmacología, genética y práctica clínica. El punto de referencia contiene preguntas abiertas y de opción múltiple que requieren razonamiento y comprensión médicos, basándose en material que incluye exámenes de licencia médica de EE. UU. e India y bancos de preguntas de exámenes de biología universitarios.

«[Open Medical-LLM] permite a investigadores y profesionales identificar las fortalezas y debilidades de diferentes enfoques, impulsar mayores avances en el campo y, en última instancia, contribuir a una mejor atención al paciente y mejores resultados”, escribió Hugging Face en una publicación de blog.

Créditos de imagen: cara de peluche

Hugging Face posiciona el punto de referencia como una “evaluación sólida” de modelos generativos de IA relacionados con la atención médica. Pero algunos expertos médicos en las redes sociales han advertido que no se debe poner demasiado énfasis en Open Medical-LLM, para que no se produzcan implementaciones mal informadas.

En real la práctica clínica puede ser bastante extensa.

Es un gran progreso ver estas comparaciones cara a cara, pero es importante que recordemos también la magnitud de la brecha entre el entorno artificial de respuesta a preguntas médicas y la práctica clínica real. Por no hablar de los riesgos idiosincrásicos que estas medidas no pueden tener en cuenta.

– Liam McCoy, Doctor en Medicina y Maestría en Ciencias (@LiamGMcCoy) 18 de abril de 2024

Clémentine Fourrier, investigadora de Hugging Face y coautora del blog, está de acuerdo.

«Estas clasificaciones sólo deben utilizarse como una primera aproximación [generative AI model] explorar para un caso de uso determinado, pero siempre es necesaria una fase de prueba más profunda para examinar las limitaciones y la relevancia del modelo en condiciones del mundo real», respondió Fourrier. en X. «Médico [models] Los pacientes no deben utilizarlos solos, sino que deben capacitarse para que se conviertan en herramientas de apoyo para los médicos. »

Esto recuerda la experiencia de Google cuando intentó llevar una herramienta de detección de retinopatía diabética mediante IA a los sistemas de salud tailandeses.

Google creó un Sistema de aprendizaje profundo que escanea imágenes del ojo., en busca de signos de retinopatía, una de las principales causas de pérdida de visión. Pero a pesar de la gran precisión teórica, la herramienta resultó poco práctica en pruebas del mundo realfrustrando tanto a los pacientes como a las enfermeras con resultados inconsistentes y una falta general de armonía con las prácticas de campo.

Es revelador que de los 139 dispositivos médicos relacionados con la IA que la Administración de Alimentos y Medicamentos de EE. UU. ha aprobado hasta la fecha, ninguno usa IA generativa. Es excepcionalmente difícil probar cómo se trasladará el rendimiento de una herramienta de IA generativa en el laboratorio a hospitales y clínicas ambulatorias y, quizás lo más importante, cómo los resultados podrían cambiar con el tiempo.

Esto no quiere decir que Open Medical-LLM no sea útil o informativo. La clasificación de resultados, como mínimo, nos recuerda cómo mal Los modelos responden preguntas básicas de salud. Pero Open Medical-LLM, y ningún otro punto de referencia, no sustituye las pruebas del mundo real cuidadosamente consideradas.

Este artículo se publicó originalmente en TechCrunch en https://techcrunch.com/2024/04/18/hugging-face-releases-a-benchmark-for-testing-generative-ai-on-health-tasks/

También te puede interesar

-

La red social Butterflies AI agrega una función que te convierte en un personaje de IA

-

Capture cada momento como un profesional con la cámara más potente del Galaxy Z Flip hasta el momento – Samsung Newsroom México

-

Epiroc lanza un nuevo equipo de perforación de producción de pozos largos

-

Caroline Doherty está satisfecha con los resultados del Leaving Cert de los estudiantes de Moville

-

En imágenes: gran revuelo en la jornada de puertas abiertas de los apicultores de Laois – Página 1 de 9